Was kratzt da so? Wie Web-Scraper-Bots die Rentabilität Im E-Commerce untergraben

Bots sind für E-Commerce-Unternehmen wie Insekten für den Garten: Manche sind nützlich, andere schädlich. Bots können Traffic auf Ihre Website bringen, Traffic auf eine andere gefälschte Website umleiten oder andere schädliche Pläne verfolgen, z. B. Credential Stuffing.

In letzter Zeit hat eine Art von Bot besonders die Aufmerksamkeit von E-Commerce-Unternehmen auf sich gezogen: Web-Scraper-Bots. Durch ihre Fähigkeit, unerkannt zu bleiben, können diese Bots heimlich den Gewinn ihrer Opfer schmälern.

Was ist ein Scraper-Bot?

Übersetzt bedeutet der Name „Sammler-Bot“. Diese Bots sammeln alle öffentlich verfügbaren Dateien und Inhalte einer Website – z. B. Bilder, Produktinformationen, Preise und Bestände.

Diese Inhalte können dann auf verschiedene Weise genutzt werden. Zum Beispiel können Wettbewerbsanalysen durchgeführt werden, einschließlich Produktpreise, Rabatte, Bestand sowie Produkt-SKU-Nummern, -Kategorien und -Beschreibungen. Oft werden auch legitime Websites für Phishing-Angriffe oder billige Markenimitationen kopiert und Kunden auf diese Websites gelockt.

Auch weniger schädliche Web-Scraper können die Website-Performance verringern und die Rechen- und Serverkosten in die Höhe treiben, indem die Website mit GET-Anfragen überflutet wird. Unabhängig von ihrem Zweck können Scraper-Bots den Umsatz beeinträchtigen, IT-Kosten steigern und das Kundenerlebnis verschlechtern – zu Ihrem Wettbewerbsnachteil.

Wir haben dieses Phänomen – und mögliche Schutzmaßnahmen für E-Commerce-Unternehmen – in einem neuen SOTI-Bericht (State of the Internet) „Web-Scraper im E-Commerce: Die Gefahr für Ihr Geschäft“ untersucht.

Headless Browser: Eine schwer zu erkennende Gefahr

Was Scraper-Bots von anderen unterscheidet und so gefährlich macht, ist dass der wirtschaftliche Schaden oft nicht sofort ersichtlich ist. Die Erkennung dieser schädlichen Bots ist schwierig, weil sie teilweise Headless Browser (d. h. Browser ohne grafische Nutzeroberfläche, die häufig zum Testen – und Scraping – von Websites verwendet werden) nutzen. Dadurch sind sie äußerst schwer zu fassen.

Wichtige Anwendungsfälle mit Auswirkungen auf Unternehmen

Bei unseren Forschungen stießen wir auf Web-Scraper-Bots, die für zahlreiche unerwünschte Aktivitäten verwendet werden, darunter:

Erstellung gefälschter Websites

Bestandsmanipulation

Erfassung von Informationen

Erstellung gefälschter Websites

Unternehmen im Reise- und Gastgewerbe sind ein Hauptziel für Scraper-Bots. Diese erfassen hier Inhalte und richten gefälschte Reservierungsseiten ein, um Kreditkartennummern und andere personenbezogene Daten zu stehlen.

Bestandsmanipulation

Ein weiterer Anwendungsfall ist die Bestandsmanipulation, wobei Spekulanten gezielt Websites anpingen, um neu verfügbare Produkte zu finden. Diese werden dann in den Warenkorb gelegt, wodurch sie legitimen Kunden nicht mehr zur Verfügung stehen. Dies geschieht oft während der Weihnachtszeit, wenn Online-Einkäufe auf dem Höchststand sind und jeder Euro zählt.

Das kann sich auch auf die Suche auswirken, da andere Einzelhändler in den Ergebnissen erscheinen, wenn der Artikel auf der manipulierten Website „nicht vorrätig“ ist. So wird nicht nur der Verkäufer um seine Einnahmen gebracht und in den Suchergebnissen benachteiligt, sondern auch ehrliche Kundschaft abgeschreckt.

Erfassung von Informationen

Mit Web-Scraper-Bots werden Informationen über Wettbewerber gesammelt, z. B. Preise und Sonderangebote, wodurch Händler ihre Konkurrenten unterbieten können. Mittlerweile gibt es eine Vielzahl von Web-Scraping-Tools und -Services von Drittanbietern, um diese Informationssammlung zu erleichtern.

Es gibt sogar spezielle Konferenzen – wie ScrapeCon – wo Teilnehmer bewährte Verfahren und Techniken austauschen, um Technologien zur Abwehr von Bots zu umgehen. Obwohl das Scraping öffentlicher Inhalte im Internet an sich nicht illegal ist, verwenden viele Tools von Drittanbietern, um später schädliche Handlungen zu begehen.

Höheres Scraping-Risiko durch KI

Wie bei anderen Arten von Bedrohungen werden auch Scraper-Bots mithilfe von künstlicher Intelligenz (KI) leistungsstärker. KI-Bots sammeln nicht nur Daten, sondern extrahieren und verarbeiten diese auch.

So kann der Bot wichtige Informationen effizient erkennen und Preise, Rabatte, Bestände sowie Produkt-SKU-Nummern, -Kategorien und -Beschreibungen auswählen. Kampagnen zur Sammlung von Marktinformationen oder Spekulation können dadurch deutlich beschleunigt werden.

Der Vorteil spezieller Erkennung

Es gibt gute Nachrichten für E-Commerce-Unternehmen, die sich Sorgen wegen Web-Scraping machen. Bot-Management-Lösungen zur gezielten Erkennung und Abwehr von Scraper-Bots reduzieren risikoreichen Bot-Traffic deutlich und verbessern die Geschäftsergebnisse.

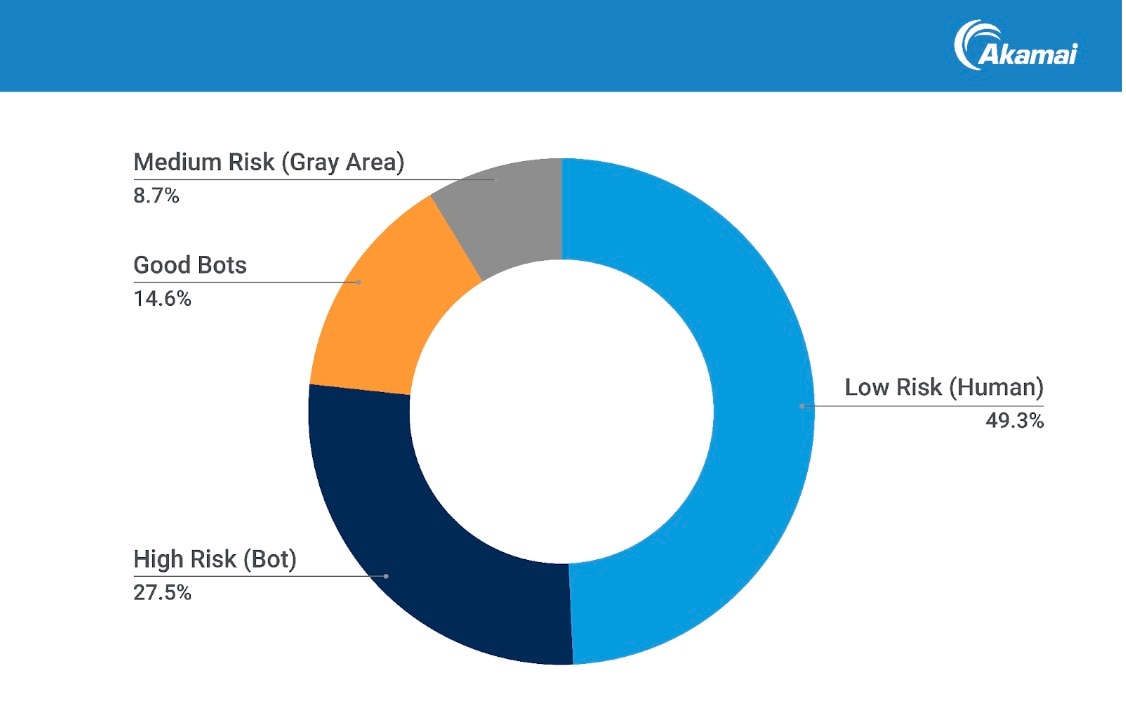

Vor Kurzem untersuchten Forscher von Akamai eine Woche lang den Traffic einer Reihe von E-Commerce-Unternehmen. Sie analysierten 6,9 Milliarden Anfragen, um diese zu identifizieren und zu charakterisieren (Abbildung 1). Dies sind die Ergebnisse:

49,3 % der Anfragen stammten von menschlichen Nutzern

42,1 % stammten von Bots (8,7 % waren gemischt oder nicht klassifiziert)

65,3 % des Bot-Traffics stammten von Scrapern, die als schädliche Bots eingestuft wurden

34,7 % des Bot-Traffics stammten von Scrapern, die als gute Bots klassifiziert wurden

Abwehr schädlicher Bots

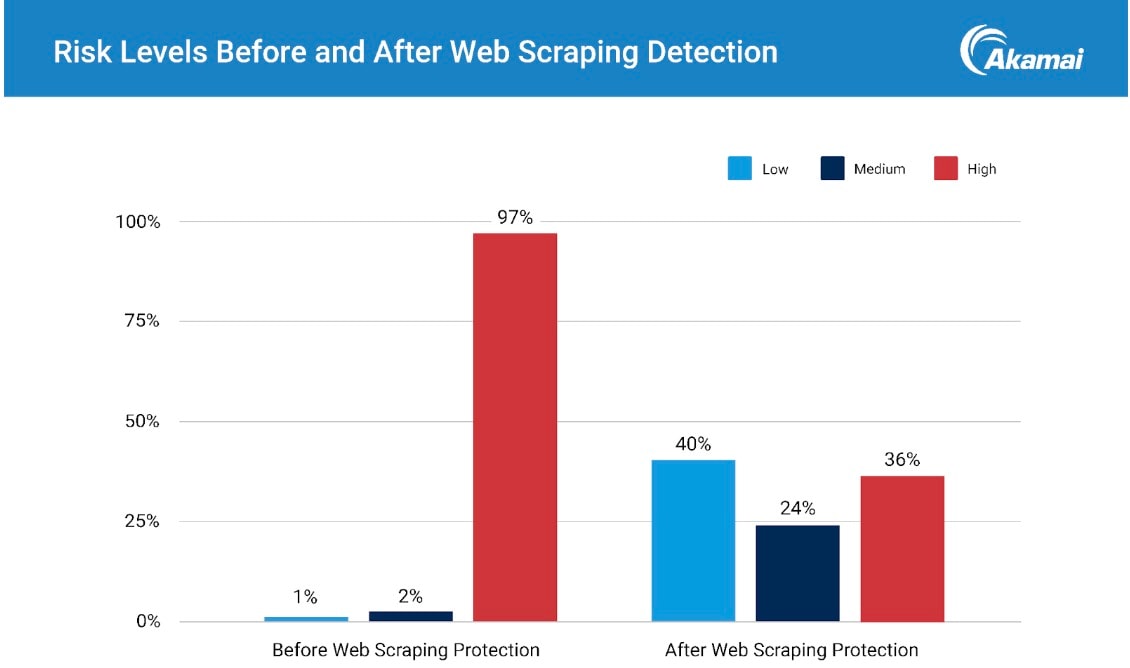

Die Differenzierung zwischen gutem und schlechtem Bot-Traffic ermöglichte eine gezielte Abwehr. Nach der Aktivierung führte die Abwehr mit Akamai Content Protector zu einer drastischen Reduzierung schädlicher Bot-Anfragen, wodurch Schadaktivitäten erheblich reduziert wurden (Abbildung 2).

Verbesserung der Geschäftsergebnisse

Die Abwehr von Web-Scrapern führte zu einem geringeren Risiko schädlicher Aktivitäten und reduzierte auch den Traffic, der Website-Ressourcen beanspruchte. Mit weniger risikoreichem Datenverkehr verbessern sich die Geschäftsergebnisse, z. B. mit verbesserter Website-Performance, höheren Konversionsraten, genaueren Websitekennzahlen und geringeren IT-Kosten. Genaue Kennzahlen für den Nutzverkehr ermöglichen es Unternehmen zudem, bessere Investitionsentscheidungen zu treffen und das Umsatzwachstum zu steigern.

Gegen die Flut an Web-Scraper-Bots

Bot-Entwickler sind schlau und ihre Taktiken werden ständig weiterentwickelt. Um schädliche Web-Scraper-Bots zu erkennen und abzuwehren, sind Tools und Fachkenntnisse erforderlich, die so hoch entwickelt sind wie die Bots selbst. Die Zusammenarbeit mit einem Partner, der über diese Fähigkeiten verfügt, kann von unschätzbarem Wert sein, um die Flut von schädlichen Web-Scraper-Bots einzudämmen.

Die Bot-Landschaft ist ständig im Wandel und stellt E-Commerce-Unternehmen immer wieder vor neue Herausforderungen. Ein Bewusstsein für die Bedrohung durch Web-Scraping ist ein entscheidender erster Schritt, um Ihr Unternehmen vor Betrug zu schützen und sicherzustellen, dass Ihr E-Commerce-Geschäft gesund, produktiv und frei von Schädlingen ist.

Mehr dazu

Mehr zu diesem Thema: Laden Sie dem neuen „State of the Internet“-Sicherheitsbericht herunter: „Web-Scraper im E-Commerce: Die Gefahr für Ihr Geschäft“.