¿Qué es eso de scraping? Cómo merman los bots de scrapers web la rentabilidad del comercio electrónico

Para las organizaciones de comercio electrónico, los bots son como insectos en un jardín: algunos son beneficiosos, pero otros son plagas destructivas. Los bots pueden llevar tráfico a su sitio, redirigir el tráfico a su propio sitio falso o ejecutar otros programas malintencionados como el Credential Stuffing.

Recientemente, una especie concreta de bot ha captado la atención de las organizaciones de comercio electrónico: los bots de scraping web. Su capacidad para evadir la detección permite a estos bots hacer scraping a sus víctimas.

¿Qué es un bot de scraping?

Como su nombre indica, estos bots se ocupan del rastreo y el raspado (scraping) de todos los datos y contenidos de acceso público (imágenes, detalles de productos, información sobre precios e información sobre disponibilidad de inventario) de un sitio web.

Este contenido se puede aprovechar de diversas formas. Se puede utilizar para análisis competitivos, por ejemplo, incluidos precios de productos, descuentos, inventario y números de SKU, categorías y descripciones de los productos. El sitio legítimo también puede duplicarse como parte de una campaña de phising o suplantación de marca para ofrecer precios a la baja que se lleven el negocio a la competencia.

Los scrapers web menos amenazantes también pueden disminuir el rendimiento del sitio web y aumentar los costes informáticos y de servidor inundando el sitio con solicitudes GET. Sea cual sea su finalidad, los bots de scraping pueden reducir los ingresos, aumentar los costes de TI y minar la experiencia del cliente, dejándole en una situación de desventaja competitiva.

Hemos analizado este fenómeno y lo que las organizaciones de comercio electrónico pueden hacer para protegerse en un nuevo informe sobre el estado de Internet (SOTI), Web scrapers en e-commerce: Un peligro para su negocio.

Navegadores sin interfaz: una amenaza evasiva

Lo que diferencia a los bots de scraping web, y hace que sean tan preocupantes, es que su verdadero impacto económico suele estar oculto bajo la superficie. Detectar estos tipos de bots maliciosos es difícil, debido en parte a su uso de navegadores sin interfaz (es decir, navegadores que carecen de una interfaz gráfica de usuario, que a menudo se utilizan para hace pruebas y scraping de sitios web). Esto los hace extremadamente evasivos.

Principales casos de uso que afectan al comercio

Nuestra investigación también ha identificado ejemplos de bots de scraping web que se utilizan para perpetrar una serie de actividades no deseadas, entre las que se incluyen:

creación de sitios falsificados

acaparamiento de inventario

recopilación de información de inteligencia

Creación de sitios falsificados

Las empresas de hostelería son un objetivo primordial de los bots de scraping, que capturan contenido y crean sitios de reserva falsos para robar números de tarjetas de crédito y otra información personal identificable.

Acaparamiento de inventario

Otro caso de uso es el acaparamiento de inventario, en el que los especuladores hacen ping repetidamente a sitios específicos en busca de productos que estén disponibles. A continuación, añaden los productos a carros de la compra, lo que hace que no estén disponibles para los clientes legítimos, a menudo durante la temporada de vacaciones, cuando las compras online alcanzan picos máximos y cada euro cuenta.

Esta técnica también puede afectar a la búsqueda, ya que otros retailers aparecen en los resultados porque el artículo está “agotado” en el sitio web atacado. Esto no solo priva al vendedor de ingresos y perjudica su posicionamiento de búsqueda, sino que es un elemento disuasivo para los clientes legítimos, que pueden decidir comprar en otro lugar en el futuro.

Recopilación de información

Los bots de scraping web también se utilizan para recopilar información de inteligencia competitiva, como datos sobre precios y ofertas especiales, que permiten a un retailer ofrecer precios más bajos que su rival. Para facilitar esta recopilación de información ha surgido una serie de herramientas y servicios de scraping web de terceros.

Incluso hay conferencias específicas, como ScrapeCon, en las que los asistentes comparten las mejores prácticas y técnicas para evadir las tecnologías de mitigación de bots. Aunque el scraping web de contenido público no es en sí ilegal, muchos utilizan herramientas de terceros para cometer actos malintencionados posteriormente.

La IA aumenta los desafíos del scraping

Al igual que ocurre con otros tipos de amenazas, los bots de scraping basados en inteligencia artificial (IA) aumentan el riesgo para las organizaciones que intentan detenerlos. Los bots de IA no solo recopilan datos, sino que también los extraen y procesan.

Esto permite al bot reconocer de forma eficaz la información esencial, lo que agiliza el proceso de selección de información sobre precios, descuentos, inventario y números SKU de productos, categorías y descripciones. Esto se puede utilizar para sobrecargar la inteligencia de la competencia o para campañas de las campañas de especulación.

El valor de la detección especializada

Hay buenas noticias para las organizaciones de comercio electrónico que están preocupadas por el scraping web. Las soluciones de gestión de bots, diseñadas para detectar y detener específicamente los bots de scraping, reducen significativamente el tráfico de bots de alto riesgo y mejoran los resultados empresariales.

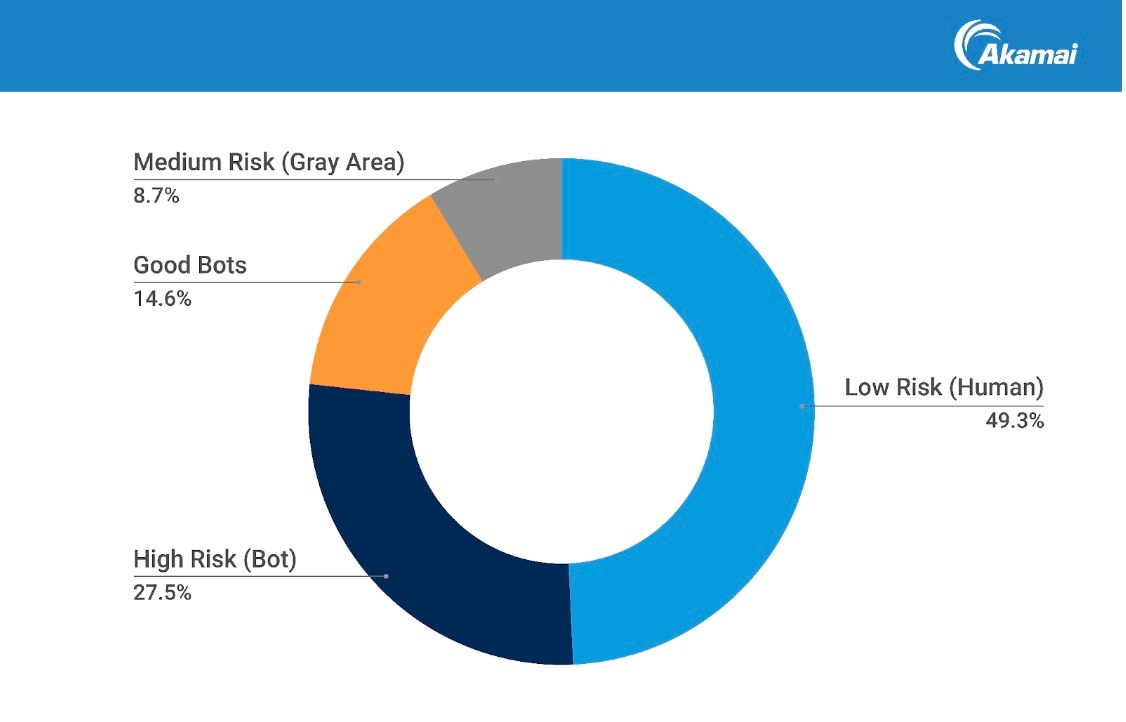

Recientemente, los investigadores de Akamai han estudiado el tráfico durante una semana de un conjunto de empresas de comercio electrónico. Analizaron 6900 millones de solicitudes para identificarlas y caracterizarlas (Figura 1). Estos son los resultados:

el 49,3 % de las solicitudes procedían de usuarios humanos

el 42,1 % provenían de bots (el 8,7 % eran mixtos o no clasificados)

el 65,3 % del tráfico de bots procedía de scrapers clasificados como bots maliciosos

el 34,7 % del tráfico de bots procedía de scrapers clasificados como buenos bots

Mitigación de los bots maliciosos

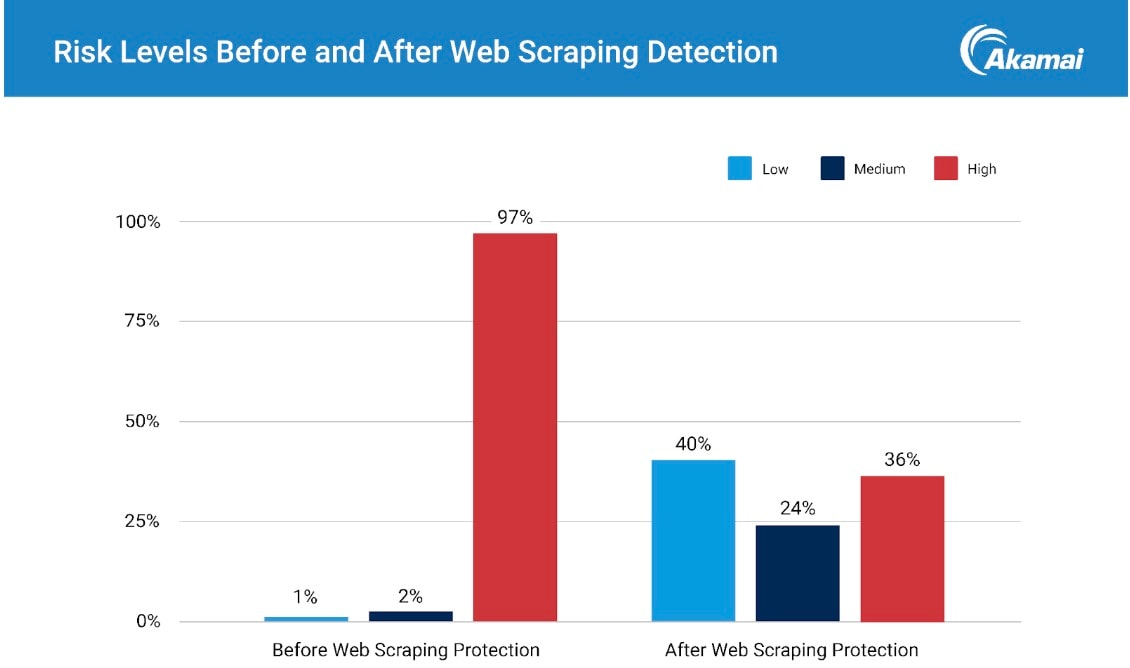

La diferenciación del tráfico de bots buenos y maliciosos permitió una mitigación dirigida. Una vez activada, la mitigación con Akamai Content Protector tuvo como resultado una reducción drástica de las solicitudes de bots de alto riesgo, lo que redujo sustancialmente la actividad maliciosa (Figura 2).

Mejora de los resultados empresariales

La mitigación de los scrapers web dio como resultado un menor riesgo de actividad maliciosa y también redujo significativamente el tráfico que consumía los recursos del sitio web. La reducción del tráfico de alto riesgo produce una serie de resultados empresariales mejorados, como un mejor rendimiento del sitio, mayores tasas de conversión, métricas del sitio más precisas y una reducción de los costes de TI. Contar con métricas precisas sobre el tráfico beneficioso también permite a las empresas tomar mejores decisiones de inversión para potenciar el aumento de los ingresos.

Contener la oleada de bots de scraping web

Los pastores de bots son inteligentes y sus tácticas están en continuo avance. La detección y mitigación de bots de scraping web maliciosos exige herramientas y conocimientos tan sofisticados como los propios bots. Trabajar con un partner que disponga de estas capacidades puede ser de un valor incalculable para contener la oleada de bots de scraping web maliciosos.

El panorama de los bots está en continua evolución y plantea nuevos desafíos de seguridad a las organizaciones de comercio electrónico. Comprender la amenaza del scraping web es un primer paso fundamental para proteger a su empresa de las pérdidas por fraude y para garantizar que su negocio de comercio electrónico sea saludable, productivo y esté libre de plagas.

Más información

Lea la historia al completo: Descargue el nuevo informe sobre el estado de Internet (SOTI), Web scrapers en e-commerce: Un peligro para su negocio.