Che cosa fa lo scraping? In che modo i bot dei web scraper possono erodere i profitti dell'e-commerce

Per le organizzazioni di e-commerce, i bot sono come gli insetti in un giardino: alcuni sono benefici, altri sono distruttivi. I bot possono introdurre traffico in un sito, reindirizzare il traffico ad un proprio sito fittizio o eseguire schemi dannosi, come il credential stuffing.

Di recente, una particolare specie di bot ha attirato l'attenzione delle organizzazioni di e-commerce: i bot dei web scraper dannosi. La loro capacità di eludere il rilevamento consente a questi bot di erodere segretamente il fatturato delle loro vittime.

Che cos'è un bot scraper?

Come suggerisce il nome, questi bot si introducono in un sito per esfiltrare tutti i dati e i contenuti pubblicamente accessibili (ad es., immagini, dettagli dei prodotti, dettagli sui prezzi e informazioni sulla disponibilità dell'inventario)

in modo da poterli sfruttare in vari modi, ad esempio, per analisi della concorrenza, inclusi prezzi dei prodotti, sconti, inventari e numeri SKU dei prodotti, categorie e descrizioni. Il sito legittimo può essere anche duplicato come parte di una campagna di phishing o di impersonificazione del brand per battere la concorrenza sui prezzi.

I web scraper meno pericolosi possono comunque diminuire le performance del sito e far aumentare i costi legati all'elaborazione e ai server inondando il sito con richieste GET. Qualunque sia il loro scopo, i bot scraper possono ridurre il fatturato, incrementare i costi dell'IT e far peggiorare le customer experience, lasciando la vostra azienda svantaggiata rispetto alla concorrenza.

Esploriamo questo fenomeno (e cosa possono fare le organizzazioni di e-commerce per proteggersi) in un nuovo rapporto sullo stato di Internet (SOTI) dal titolo Nuovi modi per erodere la redditività: l'impatto dei web scraper sull'e-commerce.

I browser headless: una minaccia elusiva

Cosa rende i bot dei web scraper diversi (e pericolosi) è rappresentato dal fatto che il loro reale impatto economico viene spesso nascosto sotto la superficie. Il rilevamento di questi tipi di bot dannosi è difficile, in parte a causa del loro uso dei browser headless (ossia, di browser senza un'interfaccia utente grafica, spesso usati per eseguire test ed esfiltrare i dati dei siti web), il che li rende estremamente elusivi.

I principali casi di utilizzo che influiscono sul commercio

La nostra ricerca ha anche identificato alcuni esempi di bot dei web scraper che vengono usati per compiere una serie di attività indesiderate, tra cui:

Creazione di siti contraffatti

Furto di inventari

Raccolta di informazioni

Creazione di siti contraffatti

Le aziende che operano nel settore del turismo e dei viaggi sono uno dei bersagli più importanti dei bot scraper, che esfiltrano contenuti e creano siti di prenotazione falsi per rubare i numeri delle carte di credito e altre informazioni di identificazione personale.

Furto di inventari

Un altro caso di utilizzo è il furto di inventari, in cui i criminali effettuano il ping dei siti presi di mira cercando ripetutamente i prodotti che diventano disponibili. I prodotti vengono quindi aggiunti al carrello per renderli non disponibili ai clienti legittimi, spesso durante i periodi di festività quando lo shopping online raggiunge il suo picco e anche ogni euro fa la differenza.

Questa tecnica può influire anche sulla ricerca perché altri retailer appaiono nei risultati in quanto il prodotto risulta "Esaurito" sul sito preso di mira. In tal modo, non solo il rivenditore vede sfumare i suoi ricavi peggiorando la sua posizione nelle classifiche di ricerca, ma questa tecnica funge da deterrente per i clienti legittimi, che potrebbero decidere di fare acquisti altrove in futuro.

Raccolta di informazioni

I bot dei web scraper vengono anche usati per raccogliere informazioni sulla concorrenza, come i dati relativi ai prezzi e alle offerte speciali che consentono ad un retailer di sbaragliare un suo rivale. Vari strumenti e servizi di web di terze parti sono stati resi disponibili per facilitare questa raccolta di informazioni.

Si tengono persino conferenze dedicate, come ScrapeCon, durante le quali i partecipanti condividono le best practice e le tecniche utilizzate per eludere le tecnologie di mitigazione anti-bot. Anche se il web scraping dei contenuti pubblici non è di per sé illegale, molti utilizzano strumenti di terze parti per commettere atti dannosi.

L'intelligenza artificiale alza la posta per lo scraping

Come con altri tipi di minacce, i bot scraper potenziati dall'intelligenza artificiale (AI) alzano la posta in gioco per le organizzazioni che cercano di bloccarli. I bot con AI non solo raccolgono i dati, ma li esfiltrano e li elaborano

per poter riconoscere i dati essenziali, semplificando il processo di selezione delle informazioni relative a prezzi, sconti, inventari e numeri SKU dei prodotti, categorie e descrizioni e per potenziare le campagne di esfiltrazione o l'intelligence della concorrenza.

Il valore del rilevamento specializzato

Ci sono buone notizie per le organizzazioni di e-commerce, che sono preoccupate per il web scraping. Le soluzioni per la gestione dei bot progettate per rilevare e bloccare specificamente i bot scraper hanno ridotto notevolmente il traffico dei bot ad alto rischio migliorando i risultati aziendali.

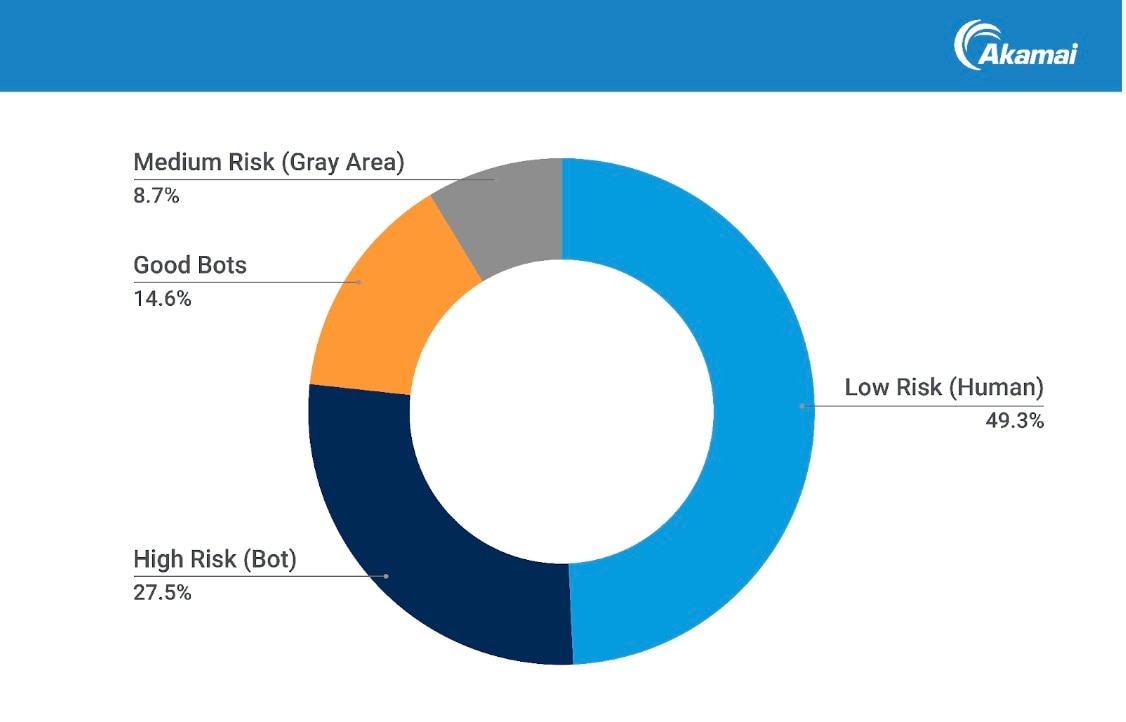

Di recente, i ricercatori di Akamai hanno studiato il traffico di una serie di società di e-commerce per una settimana, analizzando 6,9 miliardi di richieste per identificarle e caratterizzarle (Figura 1). Ecco i risultati emersi:

Il 49,3% delle richieste proveniva da utenti

Il 42,1% proveniva da bot (l'8,7% era di tipo misto o non classificato)

Il 65,3% del traffico dei bot proveniva da scraper classificati come bot dannosi

Il 34,7% del traffico dei bot proveniva da scraper classificati come bot legittimi

Mitigazione dei bot dannosi

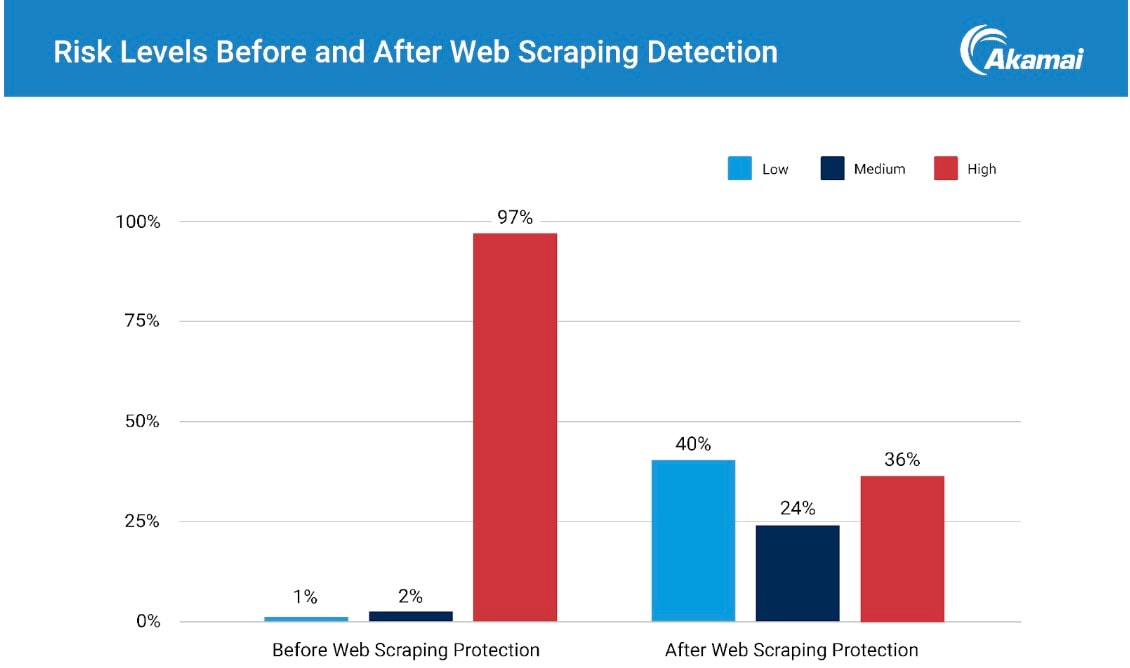

Distinguere il traffico dei bot legittimi da quello dei bot dannosi ha consentito di effettuare una mitigazione mirata. Una volta attivata, la mitigazione eseguita da Akamai Content Protector ha determinato una drastica riduzione delle richieste di bot ad alto rischio, riducendo notevolmente le attività dannose (Figura 2).

Miglioramento dei risultati aziendali

La mitigazione dei web scraper ha determinato una riduzione dei rischi delle attività dannose e ha ridotto anche notevolmente il traffico che stava esaurendo le risorse del sito web. La riduzione del traffico ad alto rischio conduce ad una serie di miglioramenti nei risultati aziendali, come performance del sito migliorate, tassi di conversione più elevati, metriche del sito più accurate e costi IT ridotti. Disporre di metriche accurate sul traffico legittimo consente anche alle aziende di prendere decisioni d'investimento migliori per favorire la crescita dei profitti.

Arginare la marea dei bot dei web scraper

Gli autori dei bot sono intelligenti e le loro tattiche migliorano costantemente. Il rilevamento e la mitigazione dei bot dei web scraper dannosi richiedono competenze e strumenti alquanto sofisticati come gli stessi bot. Collaborare con un partner con queste capacità può risultare prezioso per arginare la marea dei bot dei web scraper dannosi.

Lo scenario dei bot è in continua evoluzione e pone nuove sfide in termini di sicurezza alle organizzazioni di e-commerce. Comprendere la minaccia del web scraping è il primo passo importante verso la protezione delle attività aziendali dalle perdite causate dalle frodi e verso la realizzazione di società di e-commerce sempre più prospere e produttive senza bot dannosi.

Ulteriori informazioni

Scaricate la storia completa Scaricate il nuovo rapporto sullo stato di Internet (SOTI) dal titolo Nuovi modi per erodere la redditività: l'impatto dei web scraper sull'e-commerce.