Mit serverlosem Computing (Serverless) können Softwareentwickler Anwendungen erstellen und ausführen, ohne die Server und Backend-Infrastruktur verwalten zu müssen, die für die Entwicklung erforderlich sind.

Einführung in Cloudinfrastruktur

„Cloudinfrastruktur“ ist der Begriff für die Hardware- und Softwarekomponenten, die die Bereitstellung von Cloud-Computing-Services ermöglichen. Dazu gehören Server, Software, Netzwerke, Speicher und Virtualisierungstechnologie. Cloudinfrastrukturen werden in Remote-Rechenzentren bereitgestellt und über das Internet aufgerufen, um Kunden On‑Demand-Computing-Ressourcen bereitzustellen.

Wie unterscheiden sich Cloudinfrastrukturen von Cloud Computing?

Cloud Computing wird durch die Cloudinfrastruktur ermöglicht. Mit Cloud Computing können Unternehmen über das Internet auf On-Demand-Computing-Ressourcen zugreifen, z. B. für Verarbeitung, Speicher und Netzwerke. Dieser Zugriff erfolgt auf flexibler Preisbasis (Pay as you go). Da Kunden die Hard- und Software, die für die Bereitstellung dieser Computing-Ressourcen erforderlich ist, nicht mehr kaufen, installieren und verwalten müssen, können sie mit Cloud Computing Kosten senken, die Belastung ihrer IT‑Teams minimieren und insgesamt schneller skalieren, als es mit einer lokalen Infrastruktur möglich wäre.

Wie funktioniert eine Cloudinfrastruktur?

Cloudinfrastrukturen nutzen Virtualisierung, um Rechenleistung und Speicherfunktionen von der Hardware und den Servern zu entkoppeln, die sie tatsächlich bereitstellen. So können Nutzer überall auf der Welt über ihren eigenen Computer auf die Cloudinfrastruktur zugreifen und sie nutzen. Durch Virtualisierung und anschließendes Pooling einer großen Anzahl von Servern und anderer Hardware können Cloudanbieter ihren Kunden Pools virtualisierter Cloudinfrastrukturen anbieten und somit nahezu unbegrenzte Skalierbarkeit ermöglichen. Automatisierungssoftware und Verwaltungstools ermöglichen Kunden die Bereitstellung von Cloudinfrastruktur auf Self-Service-Basis sowie den Zugriff auf Computing-Ressourcen, wann immer sie diese benötigen.

Welche Komponenten umfasst eine Cloudinfrastruktur?

Eine Cloudinfrastruktur umfasst folgende Komponenten:

- Server. Das Zugpferd der Cloudinfrastruktur sind Server, die Rechenleistung liefern und Aufgaben ausführen. Dazu gehören Server, die Clouddatenbanken hosten, Webserver, die kommerzielle und andere Anwendungen bereitstellen, Mailserver, die E‑Mails über das Internet senden können, Fileserver, die riesige Datenmengen verwalten, sowie andere Servertypen.

- Speicher. Mit Cloudspeichern können Unternehmen große Datenmengen an Remote-Standorten speichern, anstatt ihren eigenen Speicher in lokalen Rechenzentren installieren und verwalten zu müssen.

- Networking. Die Netzwerkinfrastruktur umfasst physische Verkabelung, Switches, Load Balancer und Router, die die anderen Komponenten der Cloudinfrastruktur verbinden und Kunden über das Internet oder über eine private Netzwerkverbindung zur Verfügung stellen.

- Virtualisierung. Virtualisierung wird durch eine Software ermöglicht, die als Hypervisor bezeichnet wird und es mehreren Umgebungen ermöglicht, in vielen verschiedenen Konfigurationen sicher auf dieselbe zugrunde liegende Hardware zuzugreifen. So können Verbraucher effektiv die Rechen- und (Arbeits-)Speicherressourcen auswählen, die sie benötigen. Nachdem Rechenleistung und Speicherressourcen vom Server entkoppelt wurden, erstellt die Virtualisierungstechnologie einen virtualisierten Pool zentralisierter Ressourcen, der als Cloud bezeichnet wird.

Wie unterscheiden sich Cloudinfrastrukturen von -architekturen?

Wenn „Cloudinfrastruktur“ die Bausteine des Cloud Computings beschreibt, steht der Begriff „Cloudarchitektur“ für die Art und Weise, wie diese Komponenten kombiniert werden, um Cloud-Computing-Services bereitzustellen.

Welche unterschiedlichen Modelle gibt es für den Einsatz von Cloudinfrastrukturen?

Es gibt drei grundlegende Cloudarchitekturen, die Cloudinfrastruktur auf unterschiedliche Weise kombinieren.

Private Clouds sind Cloudinfrastrukturen, die jeweils nur einem Mandanten oder einem Unternehmen bereitgestellt werden, aber hierbei die Flexibilität und Geschwindigkeit der Cloud beibehalten. Das Unternehmen kann Eigentümer und Verwalter der Private Cloud sein oder die Infrastruktur von einem Private-Cloud-Anbieter mieten. Während Mandanten in Public Clouds um Computing-Ressourcen konkurrieren können, ermöglichen Private Clouds Unternehmen mehr Kontrolle und eine einheitlichere Verwaltung ihrer Infrastruktur-Ressourcen, kritischen Anwendungen und sensiblen Daten.

Public Clouds sind Cloudinfrastrukturen, die Drittanbietern oder Cloud-Service-Anbietern gehören und von ihnen betrieben werden. Hierbei sind diese Anbieter für die Bereitstellung, Konfiguration, Wartung und Aktualisierung der Infrastruktur verantwortlich ist. In einer Public Cloud werden Umgebungen partitioniert und mehr als einem Kunden oder Mandanten zur Verfügung gestellt. Virtualisierung ermöglicht es einem einzelnen physischen Server, Cloudressourcen mehreren Mandanten gleichzeitig bereitzustellen. Kunden greifen on demand auf Public-Cloud-Services zu und zahlen nur für den Umfang der von ihnen genutzten Computing-Services.

Hybrid Clouds bestehen aus einer Mischung aus Public- und Private-Cloud-Infrastruktur. Mit diesem Modell können Unternehmen die richtige Cloudumgebung für jeden Workload auswählen, Workloads mit großen Spitzenbelastungen in Public Clouds ausführen und die Private Cloud für Workloads mit vertraulichen Daten oder Anwendungen reservieren. Wenn Unternehmen Services aus zwei oder mehr Public oder Private Clouds nutzen, ist das Ergebnis eine Multicloud-Umgebung.

Welche Bereitstellungsmodelle gibt es für Cloudinfrastrukturen?

Die Cloudinfrastruktur wird in der Regel in einem von drei Modellen bereitgestellt, die auf den Arten von Ressourcen basieren, die ein Unternehmen benötigt.

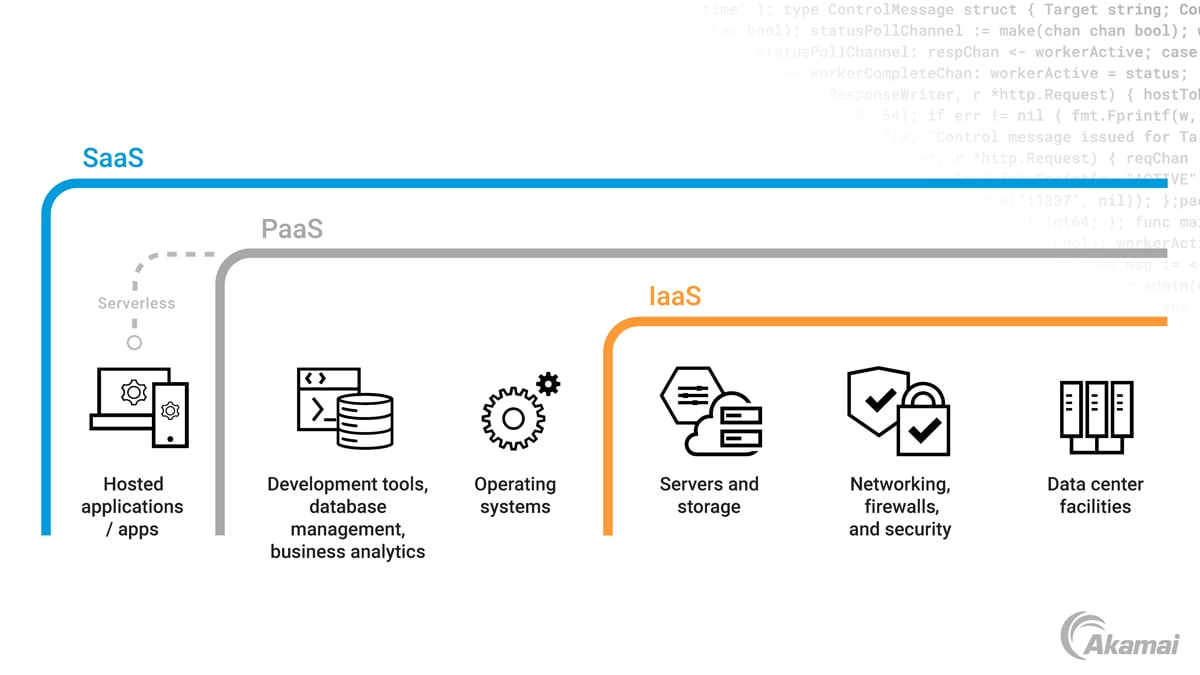

Software as a Service (SaaS) bietet On‑Demand-Zugriff auf Anwendungen und Software über das Internet, sodass Unternehmen keine Software für lokale Maschinen und Laufwerke kaufen und installieren müssen. SaaS-basierte Software wird normalerweise über eine Weboberfläche aufgerufen und kann an jedem Standort auf einer Vielzahl von Geräten verwendet werden. Da SaaS-Anbieter für die Aktualisierung der Software verantwortlich sind, stehen Nutzern mit SaaS-Technologien in der Regel die neuesten Funktionen zur Verfügung.

Platform as a Service (PaaS) bietet On‑Demand-Zugriff auf eine Computing-Plattform und ein Lösungspaket, mit dem Softwareentwickler Anwendungen oder Services erstellen, testen und ausführen können. Der Kunde ist für die Verwaltung der Anwendungen verantwortlich, die auf der Plattform ausgeführt werden, und die Daten ermöglichen es Entwicklern und Programmierern, die neuesten Lösungen für Anwendungsentwicklung und -verwaltung zu verwenden, ohne die hierzu erforderliche Infrastruktur zu erstellen und zu warten.

Infrastructure as a Service (IaaS) bietet über das Internet On‑Demand-Zugriff auf Server, Netzwerke und Speichergeräte auf flexibler Preisbasis (Pay as you go). Mit IaaS-Angeboten können Unternehmen die Bereitstellung und Verwaltung einer eigenen lokalen Infrastruktur vermeiden. Hierbei ist der Kunde für die Verwaltung des Betriebssystems, der Anwendungen und der Middleware verantwortlich.

Welche Vorteile bietet eine Cloudinfrastruktur gegenüber einer On‑Premise-Infrastruktur?

Cloudinfrastrukturen bieten viele Vorteile gegenüber ihren intern verwalteten Alternativen.

- Kosteneffizienz. Durch den Einsatz von Cloudinfrastruktur können Unternehmen die Investitionskosten für den Kauf und die Verwaltung der Hard- und Software vermeiden, die normalerweise für die Bereitstellung lokaler Computing-Ressourcen erforderlich sind. Statt eine zu große Infrastruktur bereitzustellen, um gelegentliche Nachfragespitzen abzufangen, können Unternehmen die Cloudinfrastruktur in einem nutzungsbasierten Preismodell verwenden, was zu niedrigeren Kosten und einer verbesserten Nutzung von IT‑Ressourcen führt.

- Sicherheit. Anbieter von Cloudinfrastrukturen verfügen über umfangreiches Fachwissen und nutzen erstklassige Sicherheitslösungen, um Kunden hochmoderne Cloudsicherheit zu bieten. Im Gegensatz dazu fehlt es vielen internen IT‑Teams an den erforderlichen Ressourcen, Mitarbeitern und Kompetenzen, um Daten und andere Ressourcen in On-Premise-Rechenzentren angemessen zu schützen.

- Zuverlässigkeit. Die Skalierbarkeit und Redundanz von Cloudservices bietet eine wesentlich höhere Zuverlässigkeit als interne Infrastrukturen.

- Agilität. Mit einer Cloudinfrastruktur können Unternehmen Self-Service-Funktionen nutzen, um Ressourcen schnell bereitzustellen und nicht nur Innovationen, sondern auch die Markteinführung zu beschleunigen.

Wie lauten die Nachteile einer Cloudinfrastruktur?

- Weniger Transparenz und Kontrolle. Mit einer Cloudinfrastruktur haben IT‑Teams in der Regel weniger Einblick in die tatsächliche physische Hardware, auf der ihre Workloads ausgeführt werden.

- Gemeinsame Sicherheit. Cloud-Service-Anbieter investieren zwar stark in die Sicherheit, arbeiten jedoch in der Regel nach einem Modell mit geteilter Verantwortung, bei dem Kunden für den Schutz ihrer Workloads und Daten verantwortlich sind. Hierzu müssen sie Systeme ordnungsgemäß konfigurieren, Zugriffskontrollen implementieren und Systeme überwachen. Wenn diese Zuständigkeitsverteilung von IT‑Teams missverstanden wird, kann das zu schwerwiegenden Sicherheitslücken führen.

- Verbindungsprobleme. Da der Zugriff auf die Cloudinfrastruktur über eine Internetverbindung erfolgt, können Ausfälle oder eine schlechte Internetverbindung die Performance der Prozesse beeinträchtigen, die sich auf die Cloudinfrastruktur verlassen.

Häufig gestellte Fragen (FAQ)

Eine cloudnative Anwendung ist ein Softwareprogramm, das für die Ausführung in einer Cloud-Computing-Architektur entwickelt wurde. Cloudnative Anwendungen nutzen eine Microservices-Architektur, die die Merkmale eines Cloud-Computing-Bereitstellungsmodells nutzt.

Cloud-Lastausgleich ist die Aufgabe der Verteilung von Workloads auf verfügbare Ressourcen in einer Cloud-Computing-Umgebung. Beim Lastausgleich werden Workloads optimal auf mehrere Server, Netzwerke oder andere Ressourcen verteilt, um die Performance zu verbessern, die Latenz zu reduzieren und Unterbrechungen zu vermeiden.

Ein Content Delivery Network (CDN) ist ein geografisch verteiltes Netzwerk von Points of Presence (PoP), das Inhalte schneller bereitstellen kann, indem sie von Standorten abgerufen werden, die sich nahe an den Nutzern befinden. Durch das Caching von Inhalten auf Proxyservern an verschiedenen geografischen Standorten reduzieren CDNs die Latenz und verbessern das Online-Erlebnis. Ein Cloud-CDN verlässt sich bei der Verwaltung und dem Betrieb eines CDN auf Cloud-Computing-Ressourcen statt auf Telekommunikationsservices.

Kubernetes ist ein Open-Source-System, das die Bereitstellung, Skalierung und Verwaltung containerisierter Anwendungen automatisiert. Mit einer Managed-Kubernetes-Lösung können IT‑Teams die Verantwortung für einige oder alle Aufgaben rund um die Einrichtung, Konfiguration und Verwaltung ihrer Kubernetes-Implementierung outsourcen.

Warum entscheiden sich Kunden für Akamai?

Akamai ist das Unternehmen für Cybersicherheit und Cloud Computing, das das digitale Leben unterstützt und schützt. Unsere marktführenden Sicherheitslösungen, überlegene Threat Intelligence und unser globales Betriebsteam bieten ein gestaffeltes Sicherheitskonzept, um die Daten und Anwendungen von Unternehmen überall zu schützen. Die Cloud-Computing-Lösungen von Akamai bieten als Full-Stack-Gesamtpaket Performance und erschwingliche Preise auf der weltweit am stärksten verteilten Plattform. Globale Unternehmen vertrauen auf Akamai für die branchenführende Zuverlässigkeit, Skalierbarkeit und Expertise, die sie benötigen, um ihr Geschäft selbstbewusst auszubauen.